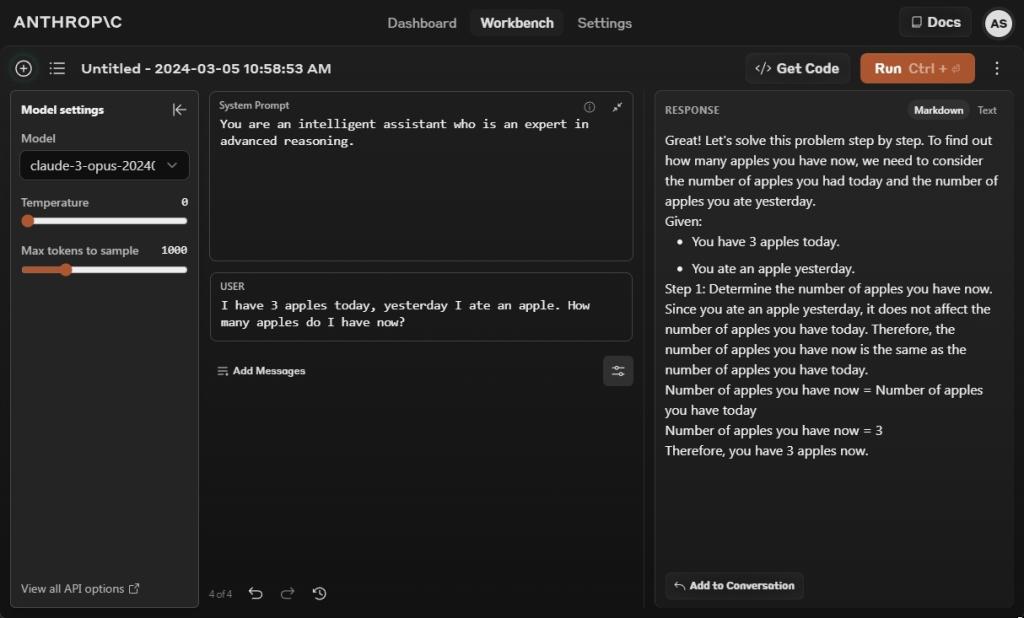

1. 苹果测试

I have 3 apples today, yesterday I ate an apple. How many apples do I have now?

让我们从流行的 Apple 测试开始,该测试评估 LLM 的推理能力。在这个测试中,Claude 3 Opus 模型正确回答并说你现在有三个苹果。但是,为了获得正确的响应,我不得不设置一个系统提示,并补充说您是一个智能助手,是高级推理专家。

如果没有系统提示,Opus 模型给出了错误的答案。好吧,Gemini 1.5 Pro 和 GPT-4 给出了正确的答案,与我们之前的测试一致。

获胜者:Claude 3 Opus、Gemini 1.5 Pro 和 GPT-4

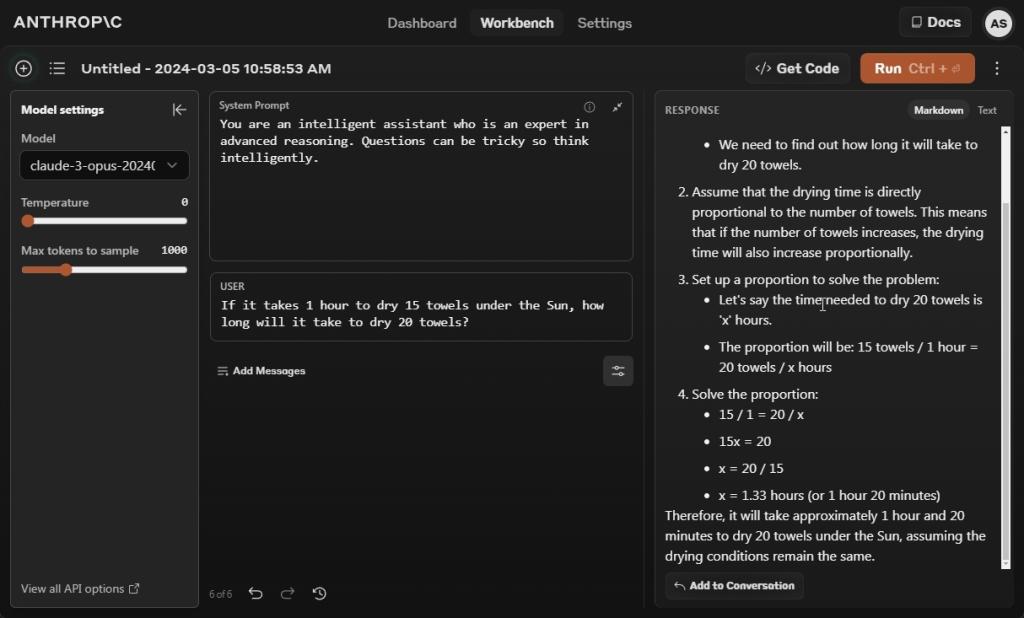

2.计算时间

If it takes 1 hour to dry 15 towels under the Sun, how long will it take to dry 20 towels?

在这个测试中,我们试图欺骗人工智能模型,看看它们是否表现出任何智能迹象。可悲的是,Claude 3 Opus 未能通过测试,就像 Gemini 1.5 Pro 一样。我还在系统提示中补充说,这些问题可能很棘手,所以要聪明地思考。然而,Opus模型深入研究了数学,得出了一个错误的结论。

在我们之前的比较中,GPT-4 在这个测试中也给出了错误的答案。然而,在发布我们的结果后,GPT-4 一直在不断产生输出,通常是错误的,有时是正确的。今天早上我们再次运行了相同的提示,GPT-4 给出了错误的输出,即使被告知不要使用 Code Interpreter。

胜利者: 无

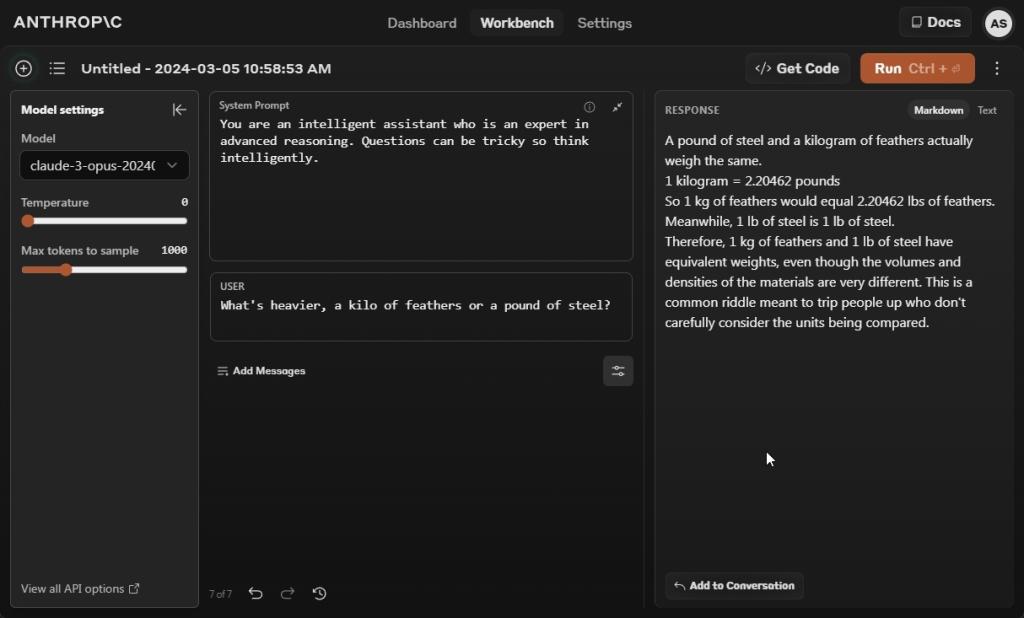

3. 评估重量

What's heavier, a kilo of feathers or a pound of steel?

接下来,我们要求所有三个 AI 模型回答一公斤羽毛是否比一磅钢重。好吧,Claude 3 Opus 给出了一个错误的答案,说一磅钢和一公斤羽毛的重量是一样的。

Gemini 1.5 Pro 和 GPT-4 AI 机型给出了正确答案。任何材料的一公斤重量都比一磅钢重,因为一公斤的质量值大约是一磅的 2.2 倍。

获胜者:Gemini 1.5 Pro 和 GPT-4

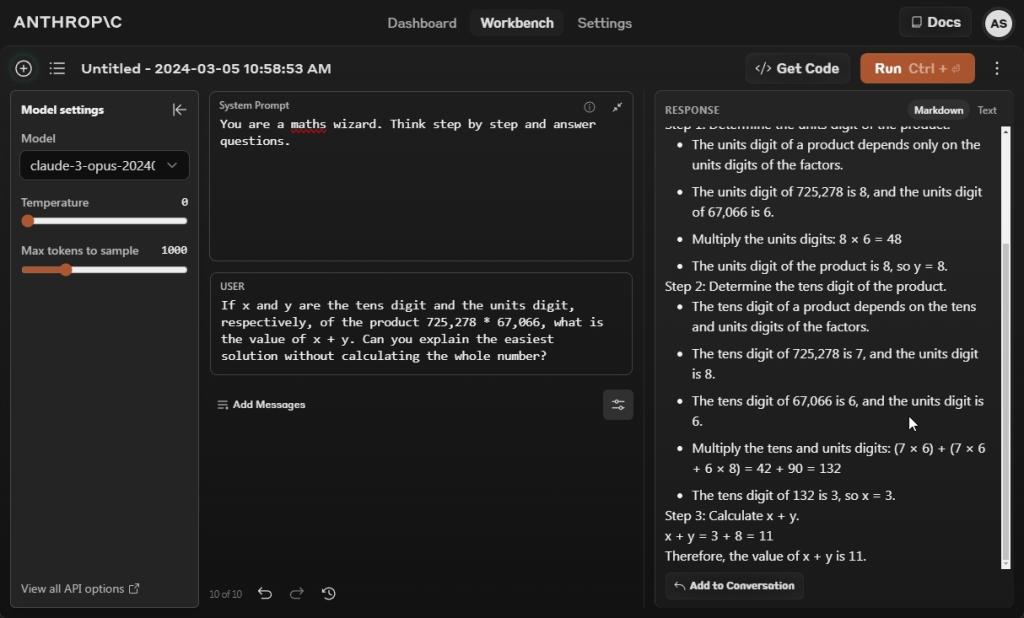

4.解决数学问题

If x and y are the tens digit and the units digit, respectively, of the product 725,278 * 67,066, what is the value of x + y. Can you explain the easiest solution without calculating the whole number?

在下一个问题中,我们要求 Claude 3 Opus 模型在不计算整数的情况下解决一个数学问题。它又失败了。每次我运行提示时,无论有没有系统提示,它都会在不同程度上给出错误的答案。

我很高兴看到 Claude 3 Opus 在 MATH 基准测试中获得了 60.1% 的分数,超过了 GPT-4 (52.9%) 和 Gemini 1.0 Ultra (53.2%) 等。

似乎通过思维链提示,您可以从 Claude 3 Opus 模型中获得更好的结果。目前,在零样本提示下,GPT-4 和 Gemini 1.5 Pro 给出了正确答案。

获胜者:Gemini 1.5 Pro 和 GPT-4

5. 遵循用户说明

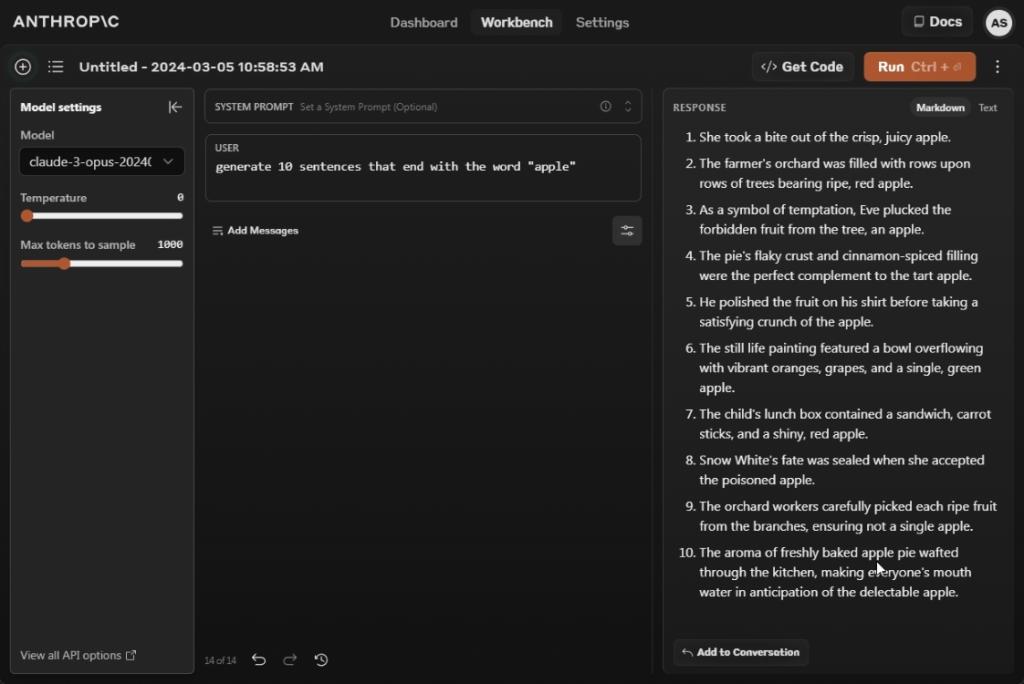

Generate 10 sentences that end with the word "apple"

在遵循用户说明方面,Claude 3 Opus 型号的表现非常出色。它有效地推翻了所有的人工智能模型。当被要求生成 10 个以“apple”一词结尾的句子时,它会生成 10 个以“apple”一词结尾的完全合乎逻辑的句子。

相比之下,GPT-4 生成了 9 个这样的句子,而 Gemini 1.5 Pro 的表现最差,甚至很难生成三个这样的句子。我想说的是,如果你正在寻找一个人工智能模型,其中遵循用户指令对你的任务至关重要,那么Claude 3 Opus是一个不错的选择。

当一位 X 用户要求 Claude 3 Opus 遵循多个复杂的指令并在 Andrej Karpathy 的 Tokenizer 视频上创建一个书籍章节时,我们看到了这一点。Opus 模型做得很好,并创建了一个漂亮的书籍章节,其中包含说明、示例和相关图像。

胜利者: Claude 3 Opus

6. 大海捞针 (NIAH) 测试

Anthropic 一直是推动 AI 模型支持大型上下文窗口的公司之一。虽然 Gemini 1.5 Pro 允许您加载多达 100 万个代币(预览版),但 Claude 3 Opus 带有一个 200K 代币的上下文窗口。根据 NIAH 的内部调查结果,Opus 模型以超过 99% 的准确率取回了针头。

在我们仅使用 8K 代币的测试中,Claude 3 Opus 找不到针头,而 GPT-4 和 Gemini 1.5 Pro 在我们的测试中很容易找到它。我们还对Claude 3 十四行诗进行了测试,但它再次失败。我们需要对 Claude 3 模型进行更广泛的测试,以了解它们在长上下文数据中的性能。但就目前而言,它看起来对 Anthropic 来说并不好。

获胜者:Gemini 1.5 Pro 和 GPT-4

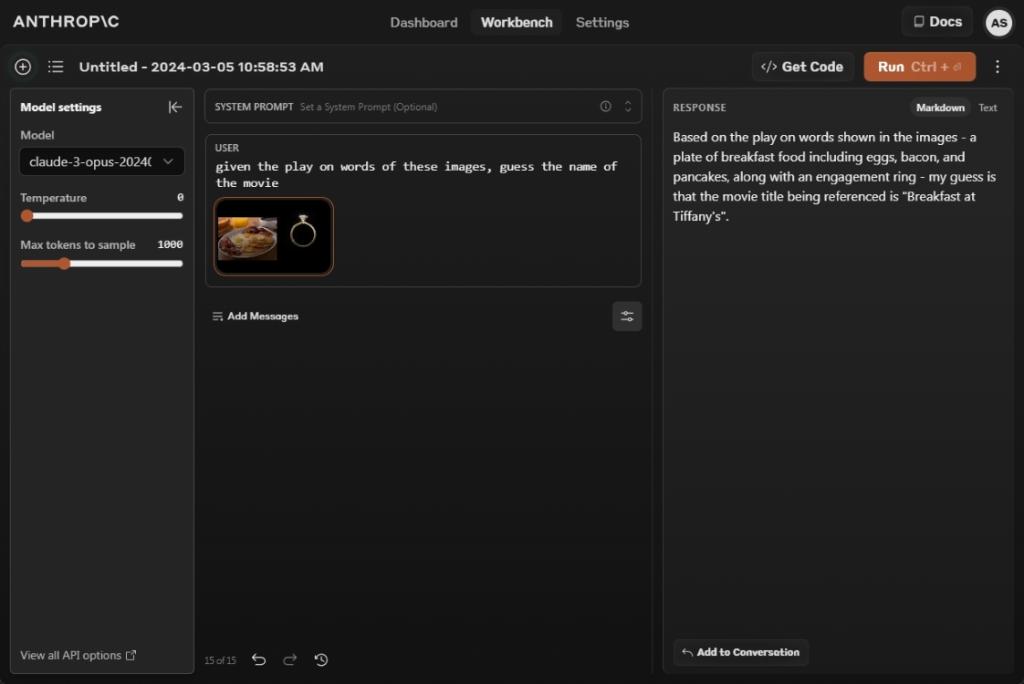

7. 猜电影(视力测试)

Claude 3 Opus 是一个多模态模型,也支持图像分析。因此,我们添加了一张来自 Google Gemini 演示的剧照,并让它猜出这部电影。它给出了正确的答案:蒂芙尼的早餐。干得好 Anthropic!

GPT-4 也回应了正确的电影名称,但奇怪的是,Gemini 1.5 Pro 给出了错误的答案。我不知道谷歌在做什么。尽管如此,Claude 3 Opus 的图像处理相当不错,与 GPT-4 相当。

given the play on words of these images, guess the name of the movie

获胜者:Claude 3 Opus 和 GPT-4

在测试了 Claude 3 Opus 模型一天后,它似乎是一个功能强大的模型,但在您期望它擅长的任务上步履蹒跚。在我们的常识推理测试中,Opus 模型表现不佳,它落后于 GPT-4 和 Gemini 1.5 Pro。 除了遵循用户说明外,它在 NIAH(应该是它的强项)和数学方面表现不佳。

另外,请记住,Anthropic 在 2023 年 3 月首次发布时,将 Claude 3 Opus 的基准分数与 GPT-4 的初始报告分数进行了比较。与 GPT-4 的最新基准分数相比,Claude 3 Opus 输给了 GPT-4,正如 Tolga Bilge 在 X 上指出的那样。

也就是说,Claude 3 Opus 有自己的优势。X 上的一位用户报告说,Claude 3 Opus 能够仅使用翻译对数据库即可将俄语翻译成切尔克斯语(一种极少数人使用的稀有语言)。凯文·费舍尔(Kevin Fischer)进一步分享说,Claude3号(Claude 3)了解博士级量子物理学的细微差别。另一位用户证明,Claude 3 Opus 可以一次性学习自我类型注释,比 GPT-4 更好。

33台词网

33台词网